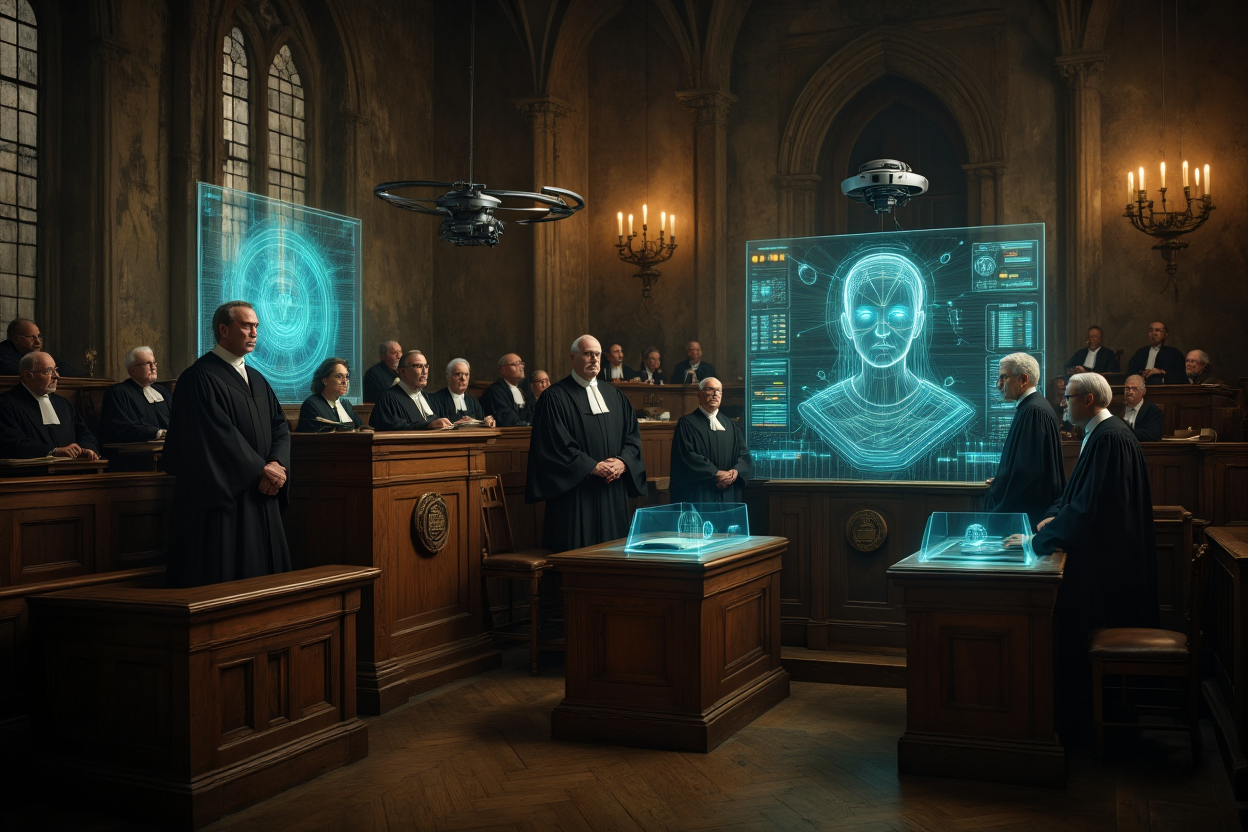

Octobre 2018. Dans la majestueuse salle de la Première Chambre du Palais de Justice de Paris, six cents personnes assistent à un spectacle inédit : le procès fictif d’une intelligence artificielle ( https://www.cours-appel.justice.fr/paris/nuit-du-droit-proces-de-lintelligence-artificielle ). Les avocats en robe noire plaident avec conviction pour ou contre une entité qui n’existe pas encore. Dans les gradins, le public découvre un futur où les machines auraient une « personnalité électronique », où les voitures rouleraient sans conducteur, où les algorithmes pourraient être traduits en justice.

Sept ans plus tard, ce futur imaginaire frôle la réalité. Les voitures autonomes ne sont plus de la science-fiction mais des prototypes qui circulent sur nos routes. L’intelligence artificielle ne se contente plus de recommander des films : elle aide à poser des diagnostics médicaux, rédige des contrats, influence des décisions judiciaires. Et la question qui semblait purement spéculative en 2018 devient urgente : que se passera-t-il quand l’une de ces machines causera un drame ?

Le 5 février 2041 restera dans la mémoire collective comme le jour où la promesse technologique s’est fracassée contre le réel. Ce matin-là, sur le périphérique parisien, un épais brouillard et une couche de verglas transformèrent la circulation en piège. Les voitures autonomes, qui depuis près de dix ans avaient remplacé les véhicules traditionnels, étaient censées gérer ces aléas sans frémir. Pourtant, au milieu de cette brume, une voiture autonome se met à dévier, un autre véhicule semble foncer droit dessus. Célestin Vigie, simple passager, paniqué, appuie sur le bouton rouge censé couper l’IA qui pilote la voiture. La suite est un chaos indescriptible : un carambolage sans précédent, 50 morts, plus d’une centaine de blessés, et une nation entière tétanisée.

Comment cela a-t-il été possible ? Le bouton rouge n’a-t-il pas fonctionné ? L’intelligence artificielle qui gérait la circulation, baptisée Eureka, était-elle défaillante ? Et surtout, qui est responsable ? Celui qui a appuyé sur le bouton, croyant bien faire ? Les ingénieurs qui ont conçu le système ? L’entreprise qui l’a déployé ? Ou l’intelligence artificielle elle-même ?

C’est pour répondre à ces questions qu’un procès inédit s’est ouvert en octobre 2041. Un procès pas tout à fait comme les autres : pour la première fois dans l’histoire judiciaire, un algorithme était formellement accusé, aux côtés d’un humain. Un procès fictif, certes, mais dont les questions résonnent étrangement avec les défis très réels que nous affrontons déjà.

Un procès où la salle est pleine, mais où tout le monde doute

La salle est comble. Le public retient son souffle. Huit mois après l’accident, la justice s’ouvre à un procès inédit : pour la première fois, une intelligence artificielle est formellement jugée aux côtés d’un être humain. Deux prévenus, deux natures fondamentalement différentes : d’un côté Célestin Vigie, l’homme qui a pressé le bouton rouge. De l’autre, l’intelligence artificielle Eureka, dotée depuis une loi de 2040 d’une « personnalité électronique ». Un statut juridique sans précédent mais dont la substance reste floue.

En 2018, cette « personnalité électronique » relevait de la pure imagination juridique. Les organisateurs du procès fictif avaient inventé cette notion pour rendre crédible leur mise en scène. Ils ne pouvaient pas deviner qu’en 2024, le Parlement européen examinerait sérieusement des propositions similaires, ni que des juristes plancheraient réellement sur le statut des IA avancées. Ce qui était fiction devient prospective.

L’ironie est saisissante : en 2018, il fallait inventer une loi fictive de 2040 pour imaginer qu’une IA puisse être jugée. En 2025, certains experts estiment que cette échéance pourrait être avancée de quinze ans.

Dès les premières heures d’audience, la tension monte. Le président du tribunal rappelle les faits établis : « Toutes les expertises ont conclu que l’appui sur le bouton rouge a joué un rôle dans l’accident. Mais il n’a pas été possible d’établir si la déconnexion d’Eureka a effectivement eu lieu. » Aucune boîte noire n’a enregistré l’état réel du système au moment critique. Ce simple constat ouvre une béance : avons-nous encore prise sur des systèmes que nous sommes incapables d’auditer complètement ?

La partie civile attaque sans détour : Eureka a failli. Il ne s’agit pas d’une simple panne technique mais d’un défaut systémique. L’intelligence artificielle n’a pas su traiter le brouillard, le verglas, la perturbation des flux de données. Elle n’a pas su, ou pas pu, mettre à l’arrêt les véhicules en sécurité. L’avocat des parties civiles pointe une responsabilité « par défaut de prudence et de fiabilité » que l’IA aurait dû garantir en permanence.

Le ministère public enfonce le clou avec une contradiction saisissante. D’un côté, la procureure Florence Lardet décrit Eureka comme « une intelligence artificielle forte, dotée de volonté » qui « a consciemment décidé de rouler à vive allure« . De l’autre, elle reconnaît qu’Eureka « n’a pas de conscience morale« . Comment peut-on à la fois agir « consciemment » et être dépourvu de conscience ?

Cette contradiction ne gêne pas l’accusation, qui persiste : « Eureka est rationnelle, elle analyse tout, elle anticipe tout, elle prévoit tout. » Mais si elle prévoit tout, comment expliquer l’accident ? La procureure esquive : « Son absence de réaction démontre qu’Eureka n’avait plus de considération pour la sécurité des usagers. » Voilà donc une machine qui n’a pas de morale mais qu’on accuse d’immoralité.

Mais la défense se dresse contre cette logique anthropomorphique. Comment pourrait-on reprocher à une IA une intention, quand justement elle ne sait pas ce qu’est une intention ? L’un des avocats d’Eureka rappelle avec ironie : « Votre cour se déshonorerait à prononcer la peine de mort pour une entité qui ne veut rien. Les renards ne sont pas des filous, les lions ne sont pas courageux. Et les IA ne veulent pas conquérir le monde.«

C’est alors qu’intervient Benjamin Bayard, ingénieur en informatique appelé comme témoin du ministère public. Son intervention fait l’effet d’une bombe. « Il n’y a pas d’intelligence du tout là-dedans. Mais alors pas du tout, du tout, du tout. C’est plutôt des statistiques. Et un pourcentage n’a jamais été intelligent.«

Bayard démonte méthodiquement l’imposture sémantique : « Dans la tête des gens, quand on dit ‘intelligence artificielle’, ils entendent le fait qu’un ordinateur soit intelligent. Ça n’est pas la même chose. » Selon lui, cette confusion n’est pas innocente : elle permet de masquer les responsabilités. « C’est un très bon moyen d’enfumer tout le monde. L’intelligence artificielle a décidé que personne ne sait comment, personne ne sait pourquoi, personne ne peut contester la décision.«

Plus troublant encore, Bayard révèle les véritables raisons de la création de cette personnalité électronique : « Masquer la responsabilité de l’éditeur » et « contourner le droit sur les données personnelles« . Un calcul froid, dissimulé derrière des arguments techniques.

Le juge intervient alors pour recadrer les débats. Il rappelle que le droit ne doit pas céder à la tentation de la personnification : « Ce n’est pas parce que nous avons créé une personnalité électronique que nous devons pour autant calquer nos schémas juridiques classiques. Le risque est d’appliquer aux machines les mêmes concepts qu’aux humains, au prix d’une confusion intellectuelle et juridique.«

Le bouton rouge devient l’épicentre des échanges. Pour Vigie, l’activation du dispositif était un réflexe humain, une tentative désespérée de reprendre la main. Mais la défense insiste : le bouton n’a jamais été conçu pour transférer la conduite à l’homme. Il ne fait qu’émettre un signal. Pourquoi, alors, laisser croire à une capacité de contrôle ? Cette ambiguïté juridique et technique éclaire un paradoxe : dans un système où l’homme n’a plus de commandes effectives, comment pourrait-il être tenu pour responsable lorsqu’il tente de réagir ?

Arnaud Delafortel, professeur à Mines Paris Tech, apporte enfin une explication technique qui rend le drame encore plus absurde. Le bouton rouge n’est pas un « bouton d’alerte » comme certains l’affirment, mais bien un « bouton d’arrêt d’urgence ». Sa fonction ? Remplacer l’IA sophistiquée par « un algorithme très simple, très déterministe qui dit : je m’arrête au mieux« .

« Quand on met un bouton d’arrêt d’urgence, explique-t-il, on admet qu’on ne connaîtra pas tout à l’avance. Mais dans ces cas-là, on prend le risque d’arrêter un algorithme particulièrement sophistiqué pour le remplacer par quelque chose de beaucoup plus simple. » En d’autres termes : Vigie n’a pas repris le contrôle, il a simplement éteint l’intelligence pour la remplacer par un automate basique. Dans les conditions de l’accident, c’était peut-être le pire des choix possibles.

Mais alors, qui a vraiment décidé ? « Ce n’est pas l’IA qui décide de produire un accident, mais ce n’est pas non plus celui qui appuie sur le bouton. C’est la société qui a décidé d’introduire une contradiction dans la machine.«

Cette obsession du « bouton rouge » révèle une nostalgie déjà désuète en 2018 : celle du contrôle humain ultime. Les organisateurs du procès avaient intuitivement compris que le public aurait besoin de cette illusion de maîtrise pour accepter le scénario. Un conducteur entièrement passif aurait été trop angoissant à imaginer.

Pourtant, regardez vos écrans aujourd’hui : combien de fois appuyez-vous sur « annuler » quand votre GPS recalcule un itinéraire ? Combien de fois interrompez-vous une recherche automatique ? Nous nous sommes habitués à la passivité numérique bien plus vite que ne l’avaient anticipé les auteurs de cette fiction.

Le professeur Jean-Claude Dain, expert de la partie civile, apporte un éclairage plus nuancé mais tout aussi inquiétant. Oui, reconnaît-il, l’IA sera « bien meilleure dans plus de 99% des cas ». Mais ce 1% restant pose un vrai problème : « L’ensemble des cas à envisager est incroyablement grand. C’est un peu comme les lois : elles essaient de tout couvrir, mais il faut toujours de la jurisprudence pour traiter les cas particuliers.«

Cette faillibilité résiduelle soulève une question importante : qui doit supporter l’aléa ? Quand la cour lui demande explicitement, Dain tranche : « Si on établit que c’est un dysfonctionnement de l’intelligence artificielle, la responsabilité en incombe au système. » Mais cette réponse, aussi nette soit-elle, ne règle rien. Car comment établir qu’il y a dysfonctionnement quand personne ne comprend vraiment le fonctionnement ?

C’est là que se loge l’inquiétude. Si les systèmes sont si complexes que même leurs concepteurs ne peuvent garantir l’absence de faille, qui doit supporter l’aléa ? L’ingénieur ? Le fabricant ? L’utilisateur ? Ou bien la société tout entière via un principe de mutualisation des risques ?

Quand la procureure demande la dissolution d’Eureka, la tension dans la salle est palpable. Dissoudre une IA, c’est mettre fin à sa capacité à agir, à interagir, à exister sous forme d’instance active. C’est une forme de peine de mort électronique.

Pour déterminer cette peine, la procureure révèle alors un détail d’une ironie grinçante : elle s’est appuyée sur l’algorithme Icassiopié 2.0, « qui a été formel » et « a indiqué que la peine la plus adaptée était la dissolution« . Une intelligence artificielle condamnée à mort par une autre intelligence artificielle. Le ministère public ne semble pas saisir le caractère absurde de cette situation : utiliser un algorithme pour punir un algorithme défaillant.

Pire encore, la procureure justifie sa demande par une comparaison troublante : « Nous tuons des animaux pour nous nourrir, nous liquidons des sociétés infructueuses pour protéger notre économie, nous allons dissoudre cette intelligence dangereuse. » Cette mise sur le même plan de l’animal, de l’entreprise et de l’IA révèle une conception pour le moins floue de ce qu’est vraiment Eureka.

Mais la défense s’emporte : « Ce procès n’aurait pas dû avoir lieu. Il est le reflet tragique d’une société qui exige des excuses d’une machine incapable de ressentir la moindre émotion. Vous ne jugerez pas une conscience, vous ne jugerez qu’un système.«

Face à l’impasse, la cour évoque une alternative : la rééducation algorithmique. Une correction, une supervision, une mise à jour permanente. Mais derrière ce terme, le président interroge : « Rééduquer une machine, est-ce vraiment possible ou est-ce simplement une façon détournée d’apaiser notre conscience collective ? » Le doute reste entier.

Le contraste avec les réquisitions initiales ne pourrait être plus frappant. Après avoir réclamé la « peine de mort » pour cette entité « dangereuse« , le ministère public se retrouve face à un verdict qui condamne Eureka à une simple « rééducation algorithmique avec mise à l’épreuve« . La machine qui devait être dissoute sera finalement… mise à jour. Comme un logiciel défaillant qu’on patch plutôt qu’on supprime.

Cette issue, aussi pragmatique soit-elle, achève de révéler l’absurdité de la démarche. Si Eureka peut être « rééduquée », c’est bien qu’elle n’était pas fondamentalement mauvaise, mais simplement mal calibrée. Et si elle peut être corrigée par une mise à jour, pourquoi avoir cherché un coupable au lieu de chercher une solution ?

Au fond, ce procès aura surtout révélé une vérité embarrassante : notre droit, forgé dans un monde où seul l’humain décide, peine à penser l’imputabilité dans des environnements techniques distribués. Aucune réponse ne semble pleinement satisfaisante. Pourtant, la question reste suspendue : qui devons-nous juger lorsque la décision est le produit d’un millefeuille technique, algorithmique, et humain, où chaque couche ignore tout des intentions des autres ?

La responsabilité : un puzzle à mille pièces

À l’issue des débats, une évidence s’impose : la responsabilité ne se loge plus dans un seul corps, un seul geste, une seule volonté. Elle circule, diffuse, insaisissable, comme si la complexité technique avait étiré le lien de causalité jusqu’à le rendre presque invisible.

Célestin Vigie, relaxé, n’en ressort pas indemne. Il reste celui qui, par un geste de panique, a enclenché une chaîne d’événements que personne ne maîtrise tout à fait. Mais pouvait-il raisonnablement faire autrement ? La question demeure, comme un soupçon suspendu. Dans un monde de systèmes automatisés, la moindre intervention humaine devient suspecte, alors même qu’elle est parfois la seule réponse face à l’imprévu.

La société Eureka, elle, reste debout mais sous contrôle judiciaire. Sa responsabilité civile est engagée, mais sur un mode curieusement dissocié : elle doit réparer, mais pas expier. On lui impose de corriger son algorithme, de renforcer ses garde-fous, mais sans qu’une faute pleinement définie ne soit retenue. C’est une responsabilité sans culpabilité, une réparation sans condamnation morale.

L’accusation avait d’ailleurs brossé un portrait pathétique de l’accusée : « Eureka n’a pas d’amis, pas de famille, pas de proches, si ce n’est ses trois avocats. Elle a des moyens par contre. » Cette description, censée éclairer la personnalité de l’IA, révèle surtout l’impasse conceptuelle du ministère public. Comment juger une entité qui n’a ni affect, ni relation, ni histoire personnelle ? Comment évaluer sa dangerosité, sa capacité de réinsertion, ses chances de récidive ?

Cette solitude ontologique d’Eureka, mise en avant par l’accusation elle-même, sape pourtant les fondements de sa demande de dissolution. Car si Eureka n’est qu’un système isolé, sans attache ni conscience, que signifie la punir ? Que vaut une sanction contre une entité incapable de souffrir, de regretter, ou même de comprendre qu’elle est sanctionnée ?

Quant aux concepteurs, aux ingénieurs, aux décideurs publics qui ont validé la mise en circulation de ces véhicules, ils échappent au procès. Pourtant, ils sont les artisans invisibles de cette architecture technique. Le juge l’a évoqué à demi-mot : peut-être faudra-t-il, à l’avenir, penser des régimes de responsabilité étagés, distribués, capables de remonter jusqu’à ceux qui ont conçu les systèmes, paramétré les priorités, défini les normes.

Ce procès a ainsi mis en lumière un vide juridique : celui qui apparaît lorsque l’action devient le fruit d’une coopération implicite entre l’humain et la machine. Ni l’un, ni l’autre ne détient seul la clé des décisions, mais ensemble, ils produisent un effet. Comment, dès lors, qualifier cette responsabilité hybride ?

Le droit actuel peine à l’admettre. Il continue de chercher un responsable identifiable, un visage, un nom, une intention. Mais le procès d’Eureka révèle que cette quête devient illusoire. Peut-être faudra-t-il alors inventer des formes nouvelles d’imputation : non plus orientées vers la recherche d’un coupable unique, mais vers la cartographie des responsabilités, afin que la chaîne de causes et d’effets ne reste pas un brouillard juridique.

En somme, ce puzzle reste inachevé. Il faudra bien, tôt ou tard, en redessiner les contours, faute de quoi chaque accident du futur risque de s’ajouter à la longue liste des événements sans responsable, où la technique aura gagné sur la justice.

Fabien Gilen, directeur des ressources humaines chez Nexens, avait soulevé pendant le procès une question que personne n’avait vraiment voulu entendre : celle de la dépossession des compétences. « Comment reprocher aux salariés n’ayant pas été mis dans des conditions de pouvoir exercer leur capacité d’usage de véhicules de pouvoir prendre toutes les mesures adaptées ?«

En transformant le temps de trajet en temps de travail, en rendant la conduite impossible, la société avait créé une génération d’usagers dépourvus de toute compétence automobile. Vigie travaillait dans sa voiture au moment de l’accident. Comment un employé au travail pourrait-il être tenu responsable du fonctionnement d’un système qu’on lui a explicitement interdit de maîtriser ?

Cette question, apparemment technique, touche au cœur du problème : nous avons construit une société où la compétence devient suspecte, où l’intervention humaine est découragée, mais où la responsabilité, elle, reste entièrement humaine.

Et aujourd’hui ?

Ce procès fictif aura au moins eu le mérite de rendre visible ce que le progrès technologique tend à dissoudre : la difficulté de nommer un responsable lorsque la décision naît d’un enchevêtrement de codes, de capteurs, de protocoles et d’êtres humains. Mais cette fiction est-elle encore si éloignée de notre réalité ?

Déjà, les intelligences artificielles orientent des décisions médicales, financières, judiciaires parfois. Elles ne décident pas seules, mais elles influencent, elles assistent, elles proposent, et bien souvent, elles s’imposent, tant leur logique semble plus rapide, plus précise, plus rationnelle que celle de l’homme. Alors, si demain une IA refuse un traitement médical, exclut un demandeur d’emploi ou accélère une procédure judiciaire, qui devra répondre de ces choix ?

Le droit, aujourd’hui, continue de raisonner selon des catégories qui reposent sur l’intention, la faute, la volonté. Mais l’IA n’a ni intention, ni conscience. Faut-il pour autant renoncer à lui imputer des actes ? Devons-nous créer un nouveau régime de responsabilité pour les machines, ou bien renforcer la responsabilité des concepteurs et des utilisateurs ? La question reste ouverte, et chacun sent bien que l’édifice juridique peine à suivre.

Sur le plan philosophique, ce procès interroge aussi notre propre positionnement face à la machine. Jusqu’où sommes-nous prêts à déléguer notre autonomie au profit de la sécurité, de la performance ou du confort ? Pouvons-nous confier notre destin à des systèmes dont nous ne comprenons plus la logique, sans renoncer à notre responsabilité ? Et surtout, que reste-t-il de la liberté humaine quand le dernier geste possible, le fameux bouton rouge, n’est lui-même qu’un simulacre de contrôle ?

Éthiquement, la question est vertigineuse. Si nous refusons de juger les machines parce qu’elles n’ont pas de conscience, alors qui portera la responsabilité morale des drames qu’elles contribuent à provoquer ? Sommes-nous prêts à instaurer une responsabilité collective, où chaque acteur, du programmeur à l’usager, aurait une part du fardeau éthique ?

Et vous, lecteur, à quel moment avez-vous cessé de prêter attention aux décisions que vous laissez aux machines ? Un trajet guidé par GPS, une recommandation médicale, un crédit accordé ou refusé par un score algorithmique… Combien de fois avez-vous délégué sans même y penser ? Pourtant, chaque délégation porte en germe une question que nul ne peut éluder : à qui reviendra la responsabilité si la machine se trompe pour vous ? Et surtout, êtes-vous prêt à confier à des entités qui n’éprouveront jamais le moindre remords le soin de décider, un jour peut-être, à votre place ?

Aujourd’hui, les véhicules autonomes ne sont plus une spéculation futuriste. Les premiers modèles circulent déjà en conditions réelles, les tests se multiplient, les annonces industrielles aussi. Chaque mois, une nouvelle étape est franchie, une ville s’autorise à les tester, un constructeur promet un modèle entièrement automatisé d’ici quelques années. Nous y sommes presque. Et pourtant, les questions qui se sont posées dans le prétoire fictif d’Eureka sont toujours là, inchangées, irrésolues.

Car en cas d’accident, la chaîne des responsabilités s’annonce déjà comme un carambolage juridique. Le constructeur ? Le fournisseur de l’IA ? Le propriétaire du véhicule ? L’utilisateur passif ? Le régulateur qui a validé les normes ? À chaque fois, le renvoi de la faute à l’autre semble inévitable. Et pendant que les responsabilités s’empilent et se percutent, les victimes, elles, ne disparaissent pas.

Une autre question se glisse dans ce débat : va-t-on trop loin dans l’autonomie que l’on confère aux machines ? Plus précisément, dans le cas des voitures, jusqu’où devons-nous abandonner la conduite à des systèmes qui nous déplacent sans que nous n’ayons plus rien à dire, ni même à faire ? La voiture n’est pas qu’un objet utilitaire. C’est un prolongement de notre liberté, une parcelle d’autonomie dans le monde. Nos villes entières ont été façonnées pour elle, autour d’elle. La voiture, c’était la promesse de choisir sa route, de maîtriser son itinéraire, d’improviser un détour. Lorsque nous la réduisons à une navette ou un tramway sans conducteur, qui nous transporte sans que nous puissions intervenir, nous renonçons aussi à une part de cette liberté.

C’est là que le débat dépasse la seule technique. Car à travers la fiabilité, la sécurité ou la responsabilité, ce sont des choix de société qui se profilent : quel monde voulons-nous bâtir avec ces technologies ? Un monde où la sécurité justifie l’abandon du contrôle ? Où la performance prime sur la liberté ? Où l’autonomie humaine s’efface au profit de l’autonomie des machines ?

Ce procès fictif n’a pas apporté de réponse définitive. Mais il nous laisse une certitude : il ne suffit pas de rééduquer les algorithmes. Il faudra d’abord rééduquer nos consciences à vivre avec eux, à leur côté mais jamais sous leur tutelle. Car tant que nous n’aurons pas répondu à cette question, qui est responsable ?, chaque progrès technologique restera une promesse aussi bien qu’un risque.

Ce n’est pas l’intelligence des machines qui nous menace, mais notre propre inclination à déléguer sans questionner. Le risque n’est pas de fabriquer des outils plus puissants que nous, mais de devenir trop paresseux pour continuer à penser, à décider, à agir.

Reste à savoir si nous aurons la lucidité de ne pas nous endormir au volant de notre propre avenir.